机器之心发布

机器之心编辑部

该上下文长度超过十三万字符,非常适合用于对多段文档进行综合分析,以及金融、法律、科研等领域的复杂任务。

近期,推理大型模型(LRMs)借助强化学习(RL)技术,在推理能力上有了显著提升。然而,这些进步主要表现在对短上下文推理任务的应对上。与此形成鲜明对比的是,如何运用强化学习来拓展 LRMs 的能力,使其能够高效地处理和推理长上下文输入,这依然是一个尚未攻克的核心难题。

阿里巴巴集团旗下的通义实验室的研究团队率先对长上下文推理强化学习的方法进行了规范化阐述,同时,他们指出了这一领域存在的两大关键难题:一是训练过程中的次优效率问题,二是优化步骤的不稳定性。

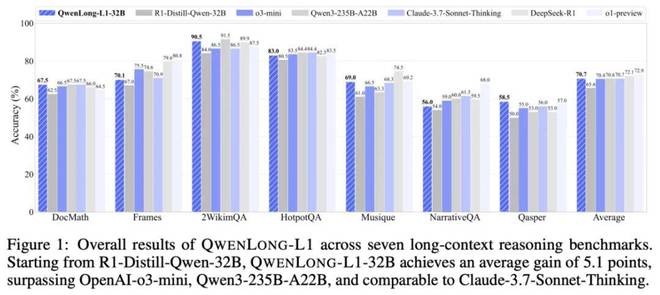

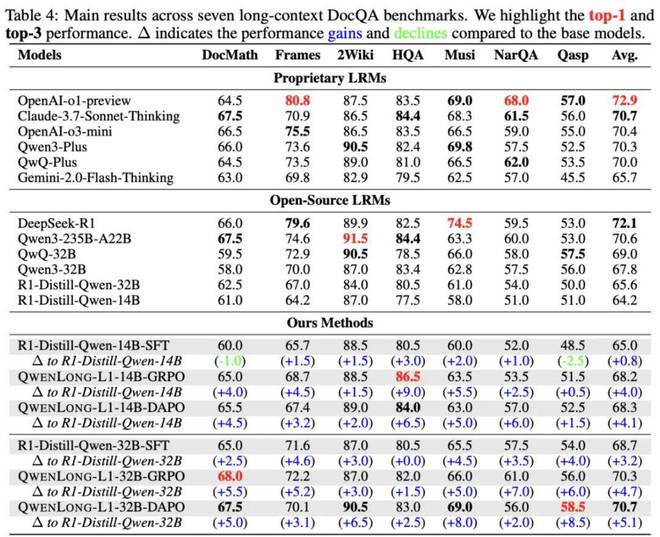

为了解决这些挑战,该团队研发了QwenLong-L1长上下文推理强化学习框架,并采用逐步扩展上下文的方法,不断优化模型在长上下文推理任务中的表现。在多个长文档问答基准测试中,QwenLong-L1-32B模型展现出卓越的效能,不仅超越了OpenAI-o3-miniQwen3-235B-A22B等顶尖模型,其性能甚至与Claude-3.7-Sonnet-Thinking相媲美。

主要贡献

1. 定义长上下文推理强化学习范式

与短上下文推理强化学习模型主要依赖内在知识进行推理不同,长上下文推理强化学习模型在运作时,必须先确定外部的重要信息,接着再融合自身的推理过程。

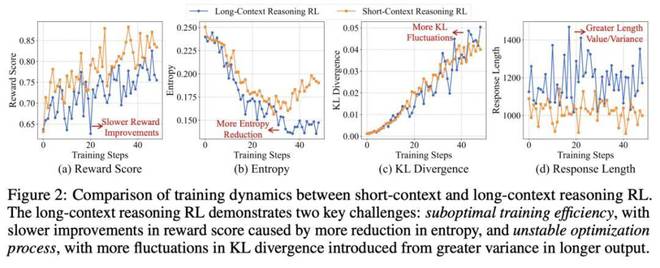

2. 识别长上下文推理强化学习关键问题

长上下文推理强化学习在训练过程中效率不高,主要体现在奖励的收敛速度较慢,以及模型输出熵的明显下降,这两者都限制了优化阶段中的探索活动。此外,这种学习训练的稳定性也较差,具体表现为KL散度出现较多突刺现象,这主要是因为输出长度较长且输入长度分布不均,进而使得方差增大,从而影响了策略更新的稳定性。

打造 QwenLong-L1 长文本上下文推理的强化学习架构。

借助渐进式上下文扩展技术与混合奖励机制,QwenLong-L1 利用强化学习技术成功实现了从简短文本向长篇文本的平稳上下文适应性。

4. 推广使用开源的QwenLong-L1-32B模型,该模型专注于长上下文文档的推理功能。

与先进的长上下文推理大型模型相较,QwenLong-L1-32B 在性能上取得了显著进步,其表现比 DeepSeek-R1-Distill-Qwen-32B 平均高出7.8%,不仅超越了诸如 OpenAI-o3-miniQwen3-235B-A22B 等顶级模型,而且与 Claude-3.7-Sonnet-Thinking 的性能相当,为长文本推理的优化贡献了基础性的技术支持。

核心技术

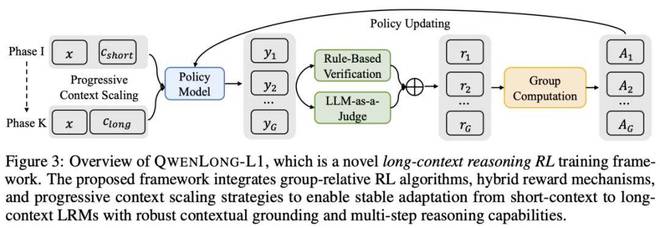

在继承传统短上下文推理强化学习框架的基础上,QwenLong-L1 主要引入了以下两项创新:一是逐步推进的上下文拓展策略,二是融合了多种奖励的机制设计。

渐进式上下文扩展技术

在训练能够进行长上下文推理的大型模型时,我们发现其优化过程具有不稳定性。为了克服这一挑战,我们设计了一个逐步扩展上下文的框架,该框架包括:通过课程引导的分阶段强化学习策略,确保从简短到长篇上下文的优化过程更加稳定;采用难度感知的回顾采样机制,优先对复杂案例进行探索;以及一个稳定的监督微调预热阶段,在强化学习训练开始前提供可靠的初始条件。

在强化学习前,通过蒸馏技术处理的长上下文推理数据对监督微调模型进行预热,以此获得一个稳定的初始策略,进而有效减少训练过程中的波动和不稳定性。

课程采用分阶段强化学习模式,将训练过程分为两个阶段。在第一阶段,输入长度设定为20K;进入第二阶段,长度扩展至60K,以逐步提升对长上下文的适应能力。在每个阶段,仅针对当前长度区间的样本进行训练,以此规避因样本长度不一而引发的优化矛盾。

在难度感知的回顾采样过程中,我们依据样本的平均奖励来动态调整难度水平,对于奖励较低即难度较高的样本,会优先保留以供后续阶段使用。在阶段 II 的训练中,这一阶段不仅涵盖了阶段 I 的难度较高的样本,而且要求模型必须持续深入探索那些复杂的案例。

混合奖励机制

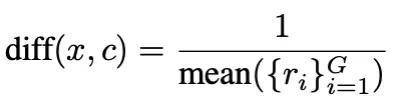

在涉及数学、编程以及逻辑推理等较为简短的上下文推理任务中,以往的研究多倾向于运用基于规则的奖励函数。但面对如开放域问答这样的长上下文推理任务,由于答案的多样性是其固有的特性,这就带来了全新的挑战。在这样的情况下,过于严格的基于规则的奖励机制可能会对有效答案的多样性产生限制,进而可能对整体性能产生不良影响。为了克服这些限制,我们设计了一种综合性的规则验证模型评价的复合激励机制,该机制通过互补性评估手段,力求在精确率和召回率之间达到一种均衡状态。

规则奖励:需利用正则表达式从模型输出中筛选出答案,需与既定答案精确对应。务必保证答案格式的准确性,以避免Reward Hacking行为。

在模型评估环节,我们选取了Qwen2.5-1.5B-Instruct作为轻量级评估工具,用以衡量预测答案与标准答案在语义上的等效程度。

组合策略是:在确定最终奖励时,采纳规则与模型评估中的最高数值,同时考虑答案的准确性以及多样性。

实验发现

主实验结果

与SFT相比,RL在性能上实现了显著进步:在R1-Distill-Qwen模型上,仅需1.6K的高质量样本经过RL训练后,性能便有显著提升;对于14B模型,平均提升了4.1;而对于32B模型,平均提升更是高达5.1。

在国内外旗舰推理模型中处于领先地位:

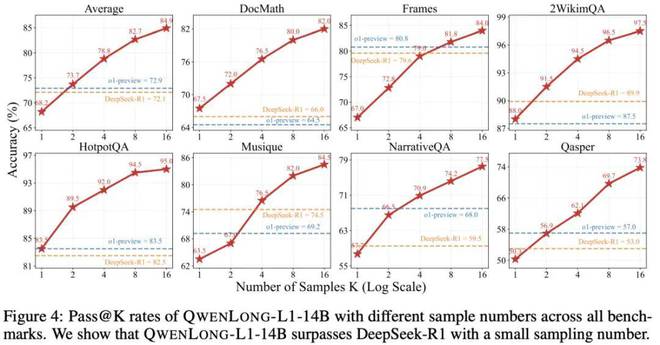

在测试时间缩放方面,性能显著提升:QwenLong-L1-14B 模型的平均 Pass@2 成绩达到了 73.7,这一成绩超过了 DeepSeek-R1(Pass@1,72.1)和 OpenAI-o1-preview(Pass@1,72.9)。

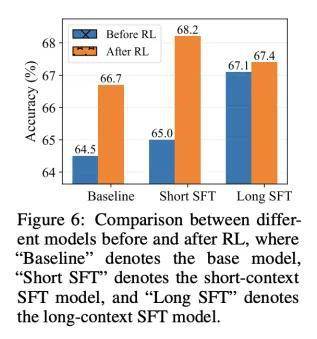

SFT 与 RL 的权衡

研究不同起点在强化学习模型中的表现:基础模型,短上下文微调模型(。