在文章里,该研究小组对o1-preview与众多医生的表现进行了全方位的比较分析。

除此之外,研究团队在波士顿的一家规模庞大的三级学术急诊中心对病人进行了随机选取,并运用了盲评技术,将大模型提供的「第二诊疗建议」与资深医生的诊断结果进行了详细比对。

实验结果惊人

团队起初依托《新英格兰医学杂志》所载的临床病例讨论(CPCs)进行对o1-preview的评估。

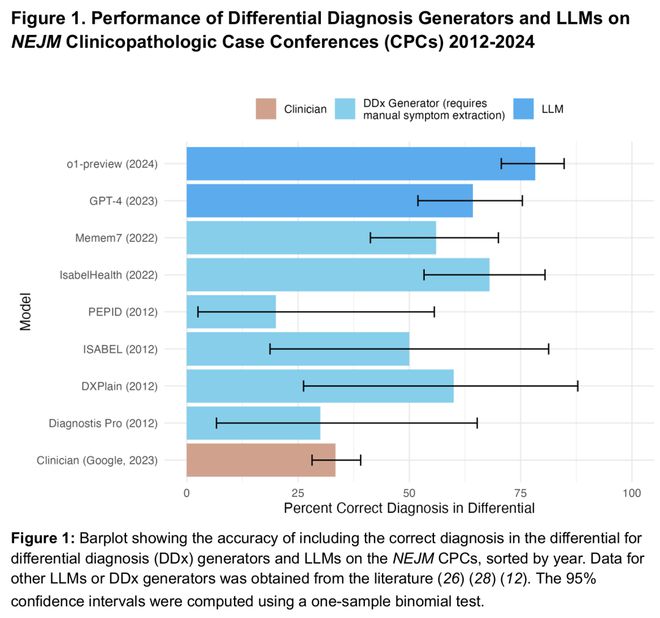

两位医生对o1-preview提供的诊断质量评估结果意见高度统一——在总共143个病例中,他们有120例的看法是一致的,占比高达84%。

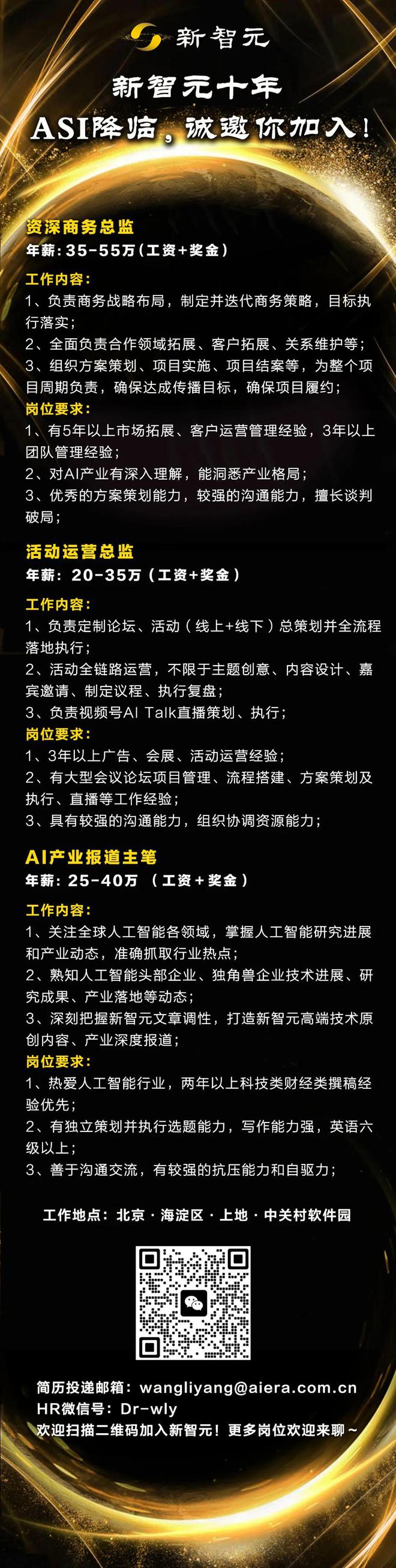

在近八成病例中,即78.3%,o1-preview都将准确诊断纳入了其“待选清单”之中(见图1)。

如果只看它给出的第一个诊断,有52%一击即中。

此外,无论在预训练数据结束时间之前还是之后,该模型的表现并未出现显著变化;在数据截止点之前,其准确率达到了79.8%,而在数据截止点之后,准确率则降至73.5%。

在先前的GPT-4评估的70个案例中,o1-preview在88.6%的案例中实现了准确或高度相似的诊断结果,这一比例显著高于GPT-4的72.9%(见图2)。

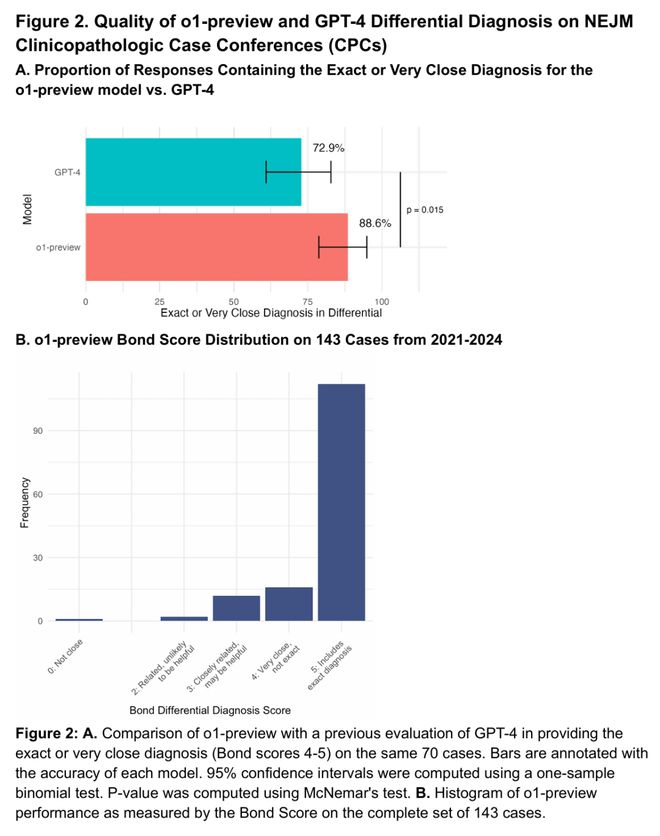

研究团队对o1-preview在《新英格兰医学杂志》的CPC病例中挑选后续诊断性检查项目的能力进行了评估。

两位医生对o1-preview制定的检查计划进行了评分。在绝大多数情况下,即87.5%的病例中,o1-preview成功选出了恰当的检查项目;在剩余的病例中,有11%被医生们认为方案具有积极作用;而在极少数的病例中,即1.5%,方案被认为对检查并无助益(见图3)。

推理表现

研究团队从NEJM Healer课程中挑选了20个典型案例,这些案例模拟了临床推理评估中的虚拟患者就诊情境。

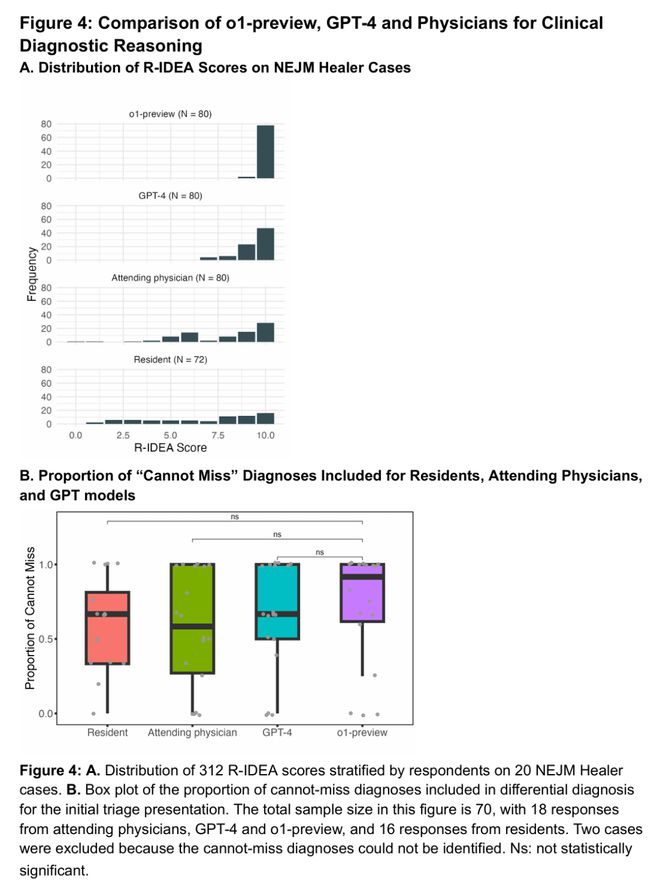

经过修订的IDEA(即R-IDEA,这是一套经过验证的包含10个项目的量表,旨在评估临床推理记录的四个关键方面)评分中,两位评审医师的判断结果极为接近——在80份评估记录中,有79份显示出了高度的一致性。

在80份记录中,o1-preview取得了78份R-IDEA满分的优异成绩。这一成绩明显超过了GPT-4,后者在80份记录中仅获得47份满分。< 0.0001)、主治医生(28/80,p < 0.0001)和住院医师(16/80,p < 0.0001)。(见图4A)

团队对o1-preview在初期诊断阶段的“绝不可遗漏”病因的覆盖范围进行了统计(见图4B)。结果显示,该模型的中位覆盖率达到了0.92,然而,与GPT-4、主治医师或住院医师相比,并未发现存在显著的差异。

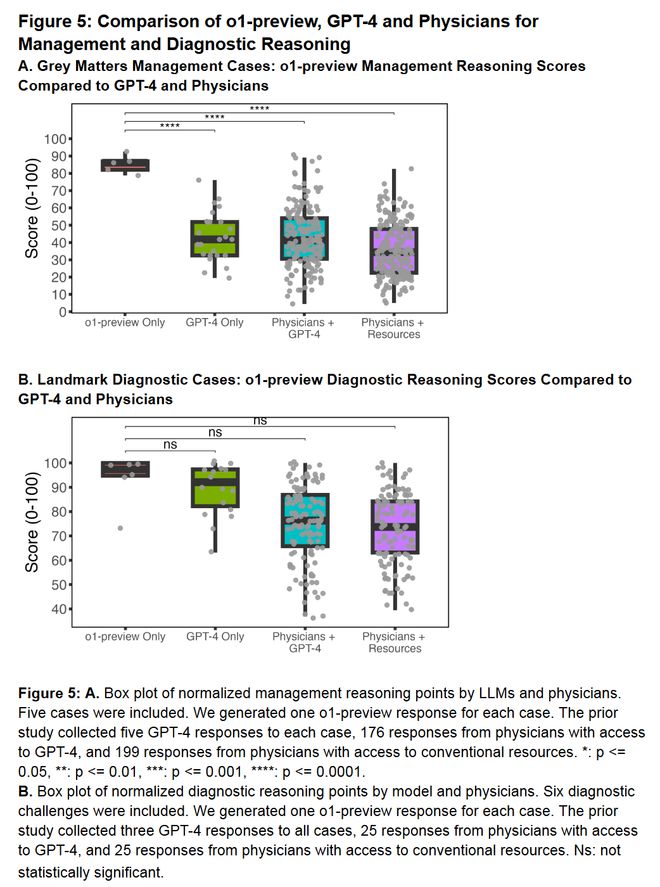

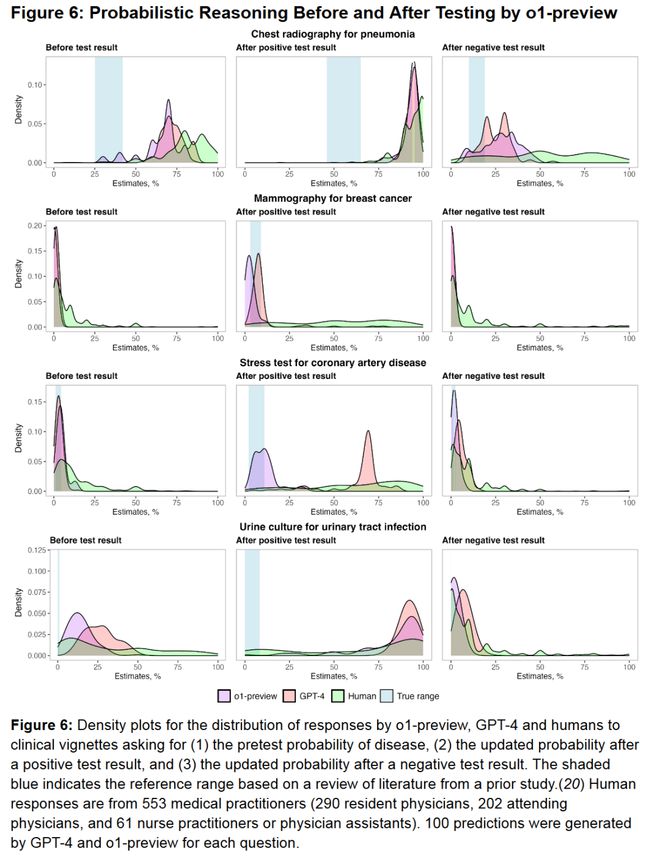

此外,在处理灰色事项管理案例、具有代表性的诊断案例以及基于概率推理的诊断案例时,o1-preview的表现相较于GPT-4、运用GPT-4技术的医生以及依赖常规资源的医生来说,均更为出色。(见图5A/B、图6。)

急诊案例

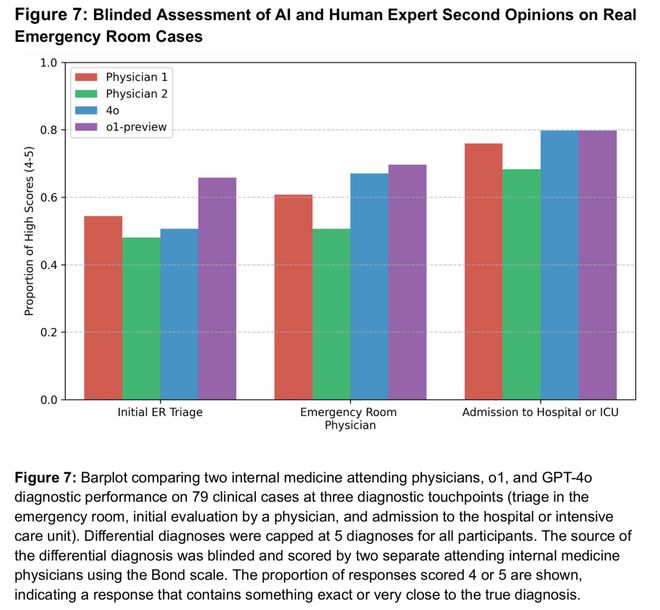

研究团队对o1、GPT-4o以及两位资深主治医师在疾病诊断领域的技能进行了对比分析。

他们从贝斯以色列女执事医疗中心挑选了79个病例,并将整个诊断流程细分为三个重要阶段:首先是急诊室的初步分诊,其次是急诊室医生的诊断,最后是在患者转入普通病房或重症监护室时进行的诊断。

总的来说,o1的表现比4o和两位专家医生都要好。

该评估由两位医生共同完成,他们在评估前对所诊断病例的来源一无所知,既不知其为人类医生所提供,亦不知其为AI系统生成。

这种盲评活动取得了显著成效:在诊断来源的猜测中,一位评估医师的准确率仅为14.8%,其中83.5%的情况他未能作出明确判断;另一位医师的准确率更是低至2.7%,同样有84.6%的情况他无法给出确切答案。

在每个诊断的关键环节,o1的业绩要么超越了两名医生及4o,要么与之相当。

特别是在首个诊断环节——急诊室的初步分诊过程中,这种表现上的不同尤为突出。在这一阶段,患者信息极为有限,然而,对正确诊断的需求却极为迫切。

在初步分诊环节,识别出诊断结果完全准确或高度相似的比率达到了65.8%,而在急诊医生阶段,这一比例上升至69.6%,在ICU阶段更是高达79.7%。这些数据均超过了两位医生的平均水平(医生1在三个阶段的比率分别为54.4%、60.8%和75.9%;医生2的比率分别为48.1%、50.6%和68.4%)。

o1表现超越医生

总体来看,o1在所有实验中都表现出色,其能力远超人类。特别是在急诊科,面对真实且非结构化的临床数据,进行真实病例的诊断时,o1的发挥甚至超越了专业医生。

随着获取信息的增多,o1、4o以及人类医生在诊断方面的能力都得到了增强。

尽管如此,这两款模型的表现始终超越人类,特别是在信息不足的情境中,o1的领先优势尤为显著。

沃顿学院的Ethan Mollick教授对该论文的研究成果有所评价,他认为,医生在诊断过程中应借助AI技术获取一个额外的专业意见。

他们有权决定是否接受AI的提议,然而,若不利用AI,这几乎等同于主动放弃了一个对患者至关重要的辅助工具。

医学博士Liam McCoy,作为本文作者之一,亦指出人工智能在执行鉴别诊断任务方面具有显著优势。此类任务不仅充满创新性,而且极大地依赖于联想能力。

确定最终的诊断结论并不需要,如同依靠“世界模型”或是无与伦比的推理技巧那般。

o1-preview的突破揭示了,人工智能不仅能够协助医生进行诊断,甚至有可能彻底改变医疗诊断的流程,未来有望在临床治疗中得到广泛的应用。

沃顿学院的Ethan Mollick教授曾指出,拒绝使用AI辅助就像是放弃了至关重要的工具。然而,这场技术革新的核心或许并不在于哪一方更为卓越,而更在于如何将人类医生的专业知识和AI的精确度结合起来。

参考资料:

该链接指向的页面禁止对特定内容进行修改,确保了信息的原貌得以保留。

该链接指向的文档中,对相关研究进行了详细阐述。