5月28日,业界知名的大模型排行榜SuperCLUE发布了最新信息,华为依托昇腾集群所训练的盘古Pro MoE大模型,在性能上表现出色,取得了卓越的成果,并在综合能力方面取得了领先地位。

目前,全球对于大型模型的角逐已经达到了高潮。在此之前,国际上的顶级大模型训练工作几乎都依赖于英伟达的GPU。而华为此次推出的盘古Pro MoE大模型,充分展示了昇腾AI计算平台在训练顶级大模型方面的实力。这一成就进一步证实了我国在AI基础设施领域的自主创新水平,为我国人工智能产业的持续发展注入了信心。

模型能力:SuperCLUE榜单上表现卓越

华为最新推出的盘古大模型家族成员盘古Pro MoE大模型,运用了混合专家架构(MoE),在参数总量控制于720亿,激活参数量达到160亿的前提下,凭借其动态激活专家网络的独特设计,展现了卓越的性能,其表现甚至可与千亿级模型相媲美。

SuperCLUE作为中文通用大模型的权威评测基准,在最新发布的总排行榜中,盘古Pro MoE取得了59分的高分,与国内其他大模型在千亿参数量级内并列第一。具体来看,该模型在逻辑推理、多轮对话、代码生成等关键能力方面,均展现出了行业内的领先水平。

创新技术:突破性提出MoGE架构

混合专家模型,简称MoE,为大型语言模型的高效运行和大规模参数化带来了新的机遇。但遗憾的是,传统的MoE架构在专家负载均衡上存在明显的缺陷,这直接导致了系统效率的瓶颈。华为的盘古团队推出了盘古Pro MoE大模型,该模型基于分组混合专家模型(Mixture of Grouped Experts, MoGE)架构。该架构在专家选择环节引入了分组策略,以此实现了跨设备的计算负载均衡。这一设计不仅有效解决了传统MoE架构中专家负载不均衡的问题,而且大幅提高了模型的训练速度和推理效果。在基于4K昇腾的大规模集群系统中,盘古Pro MoE展现出了卓越的高效训练性能。

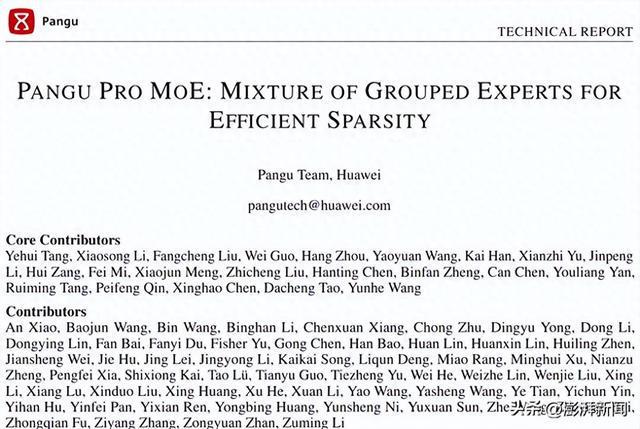

请查阅以下中文技术报告链接:https://gitcode.com/ascend-tribe/pangu-pro-moe/tree/main,其中包含了详细的技术内容。

请查阅以下英文技术报告链接:https://arxiv.org/pdf/2505.21411。

行业价值:以高效能加速AI应用落地

在企业级应用领域,盘古Pro MoE的动态负载均衡技术显著减少了云端推理的开支,并能够支持高并发和实时作业的环境;此外,它还借助轻量级的推理引擎与昇腾系列芯片相匹配,助力客户运行百亿级别的模型,从而为人工智能产业的应用开辟了新的广阔天地。

据消息,盘古Pro MoE计划向开发者群体共享模型权重,从而助力行业内的开发者依托此模型在特定领域进行创新实践。同时,该模型将深度融合到华为云的盘古大模型体系中,为金融、制造业、医疗等行业智能化转型提供必要的底层技术支持。