财联社5月31日(编辑:赵昊)亚马逊的云计算分支AWS负责人透露,该公司正全球性地加快数据中心的建设步伐,同时积极争取获取更多由英伟达最新研发的人工智能专用芯片。

5月30日周五,AWS的CEO Matt Garman向媒体透露,今年年初,该公司在墨西哥增设了一个数据中心集群,并且还在智利、新西兰以及沙特阿拉伯等国家着手建立了新的基础设施。

亚马逊先前透露,其人工智能领域业务预计将在整个年度实现数十亿美元的收益。Garman进一步指出,这一收益数据源自AWS,反映了客户对按需人工智能服务的需求规模。

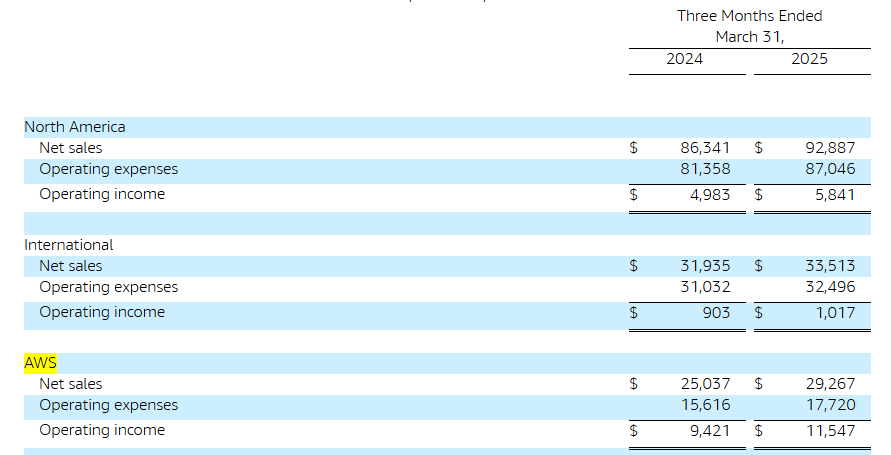

据调查,亚马逊网络服务(AWS)作为全球最大的计算资源及数据存储租赁服务公司,其市场地位超越了微软的Azure和谷歌云服务。在本月初,亚马逊发布的财务报告揭示了其云服务业务在第一季度实现了292.67亿美元的营收,这一数字较去年同期增长了17%。

然而,这一增长速度显然不及微软与谷歌的同类产品。据微软之前公布的财务报告,其Azure云服务的收入增幅达到了21%;而谷歌云服务的收入增长则高达28%。

亚马逊与微软、谷歌并肩,正加速提升其人工智能计算实力。Garman透露,亚马逊网络服务(AWS)正与英伟达携手,旨在增加对英伟达旗下高端芯片GB200的库存。目前,这些芯片已开始供AWS的客户进行测试。

先前有消息透露,英伟达的供应链联盟成员,诸如富士康、英业达、戴尔、纬创等企业,成功解决了GB200 AI服务器机架的多项技术挑战,目前其产品出货量正呈现出快速增长的趋势。

GB200人工智能机架内装配了36枚Grace核心处理器以及72枚Blackwell图形处理器,这些处理器通过英伟达的NVlink通信技术相互连接。

Garman表示:“市场需求极为旺盛。”他曾是AWS的工程部门主管,之后又转任销售部门主管,而在一年前,Garman接替了Adam Selipsky,成为了该部门的CEO。

Garman表达了他的态度,即他对于OpenAI的模型能够在AWS平台上得以部署表示出积极的欢迎之情,即便目前该AI初创企业的模型正运行于微软的服务器设施之中。

尽管如此,OpenAI在今年的早期阶段已经取得了开展其他合作项目的权限,但这仅限于微软不打算亲自承担该项业务的情况下。

Garman表示:“我们推崇并倡导所有合作伙伴在其他平台上也进行使用。我衷心期望其他企业能效仿这种做法。”

他还提到,即便亚马逊的合作伙伴Anthropic研发的AI模型Claude接入微软的云端服务,这也并无大碍。

Claude具备将服务部署至其他地区的功能,这无疑是个优点,然而,我们注意到,其大部分应用场景依然集中在AWS平台。”Garman如此陈述。