IT 之家在 4 月 12 日获得消息,字节跳动在 4 月 8 日发布了一篇博文,其 Seed 研究团队推出了 VAPO 强化学习训练框架,该框架的目标是提升大型语言模型在复杂且冗长任务中的推理能力。

现有挑战

大型语言模型(LLM)的强化学习(RL)训练中,价值导向方法(Value-based reinforcement learning methods)能够精确地追溯每个动作对后续回报的影响,并且展现出了巨大的潜力。但是,当把它应用于长链式推理(CoT)任务时,价值模型面临着三大挑战。

价值模型初始化会带来偏差;传统方法在面对复杂任务中的序列长度差异时难以适应;验证任务中的奖励信号稀疏,优化过程需要在探索与利用之间进行权衡,这些问题对价值导向方法的实际效果产生了限制。

VAPO 简介

字节跳动新推出的框架叫 VAPO,其全称为 Value Augmented Proximal Policy Optimization(增强价值的近端政策优化)。该框架基于 PPO 框架,通过三项创新技术来应对上述挑战。

VAPO 模型构建了一个细致的价值训练框架,这样就增强了模型对复杂任务的理解。接着,它引入了长度自适应广义优势估计(GAE)机制,此机制能够依据响应长度来动态地调整参数,从而优化长短序列的训练效果。最后,VAPO 将多项先前的研究技术进行了整合,形成了一个协同增效的系统。

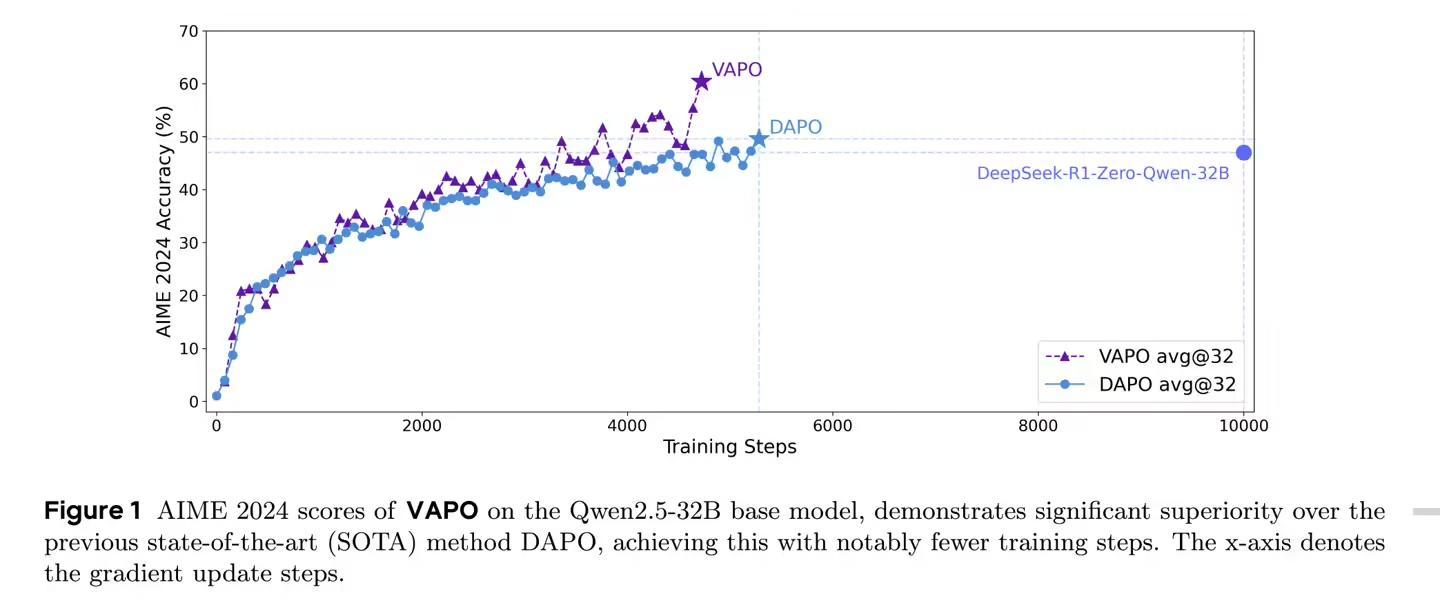

Qwen2.5 - 32B 模型在不依赖特定监督微调数据的情形下,经过 VAPO 优化后,在 AIME24 基准测试中的得分由 5 分提升到了 60.4 分。它超越了 DeepSeek R1 的 47 分,比此前 SOTA 方式 DAPO(50 分)高出 10 分,并且仅用 60%的更新步骤就达成了业界领先。

VAPO 与传统 Proximal Policy Optimization(PPO)算法相比,它改进了数学推理能力。VAPO 的训练曲线更为平滑,其优化过程也更稳定。

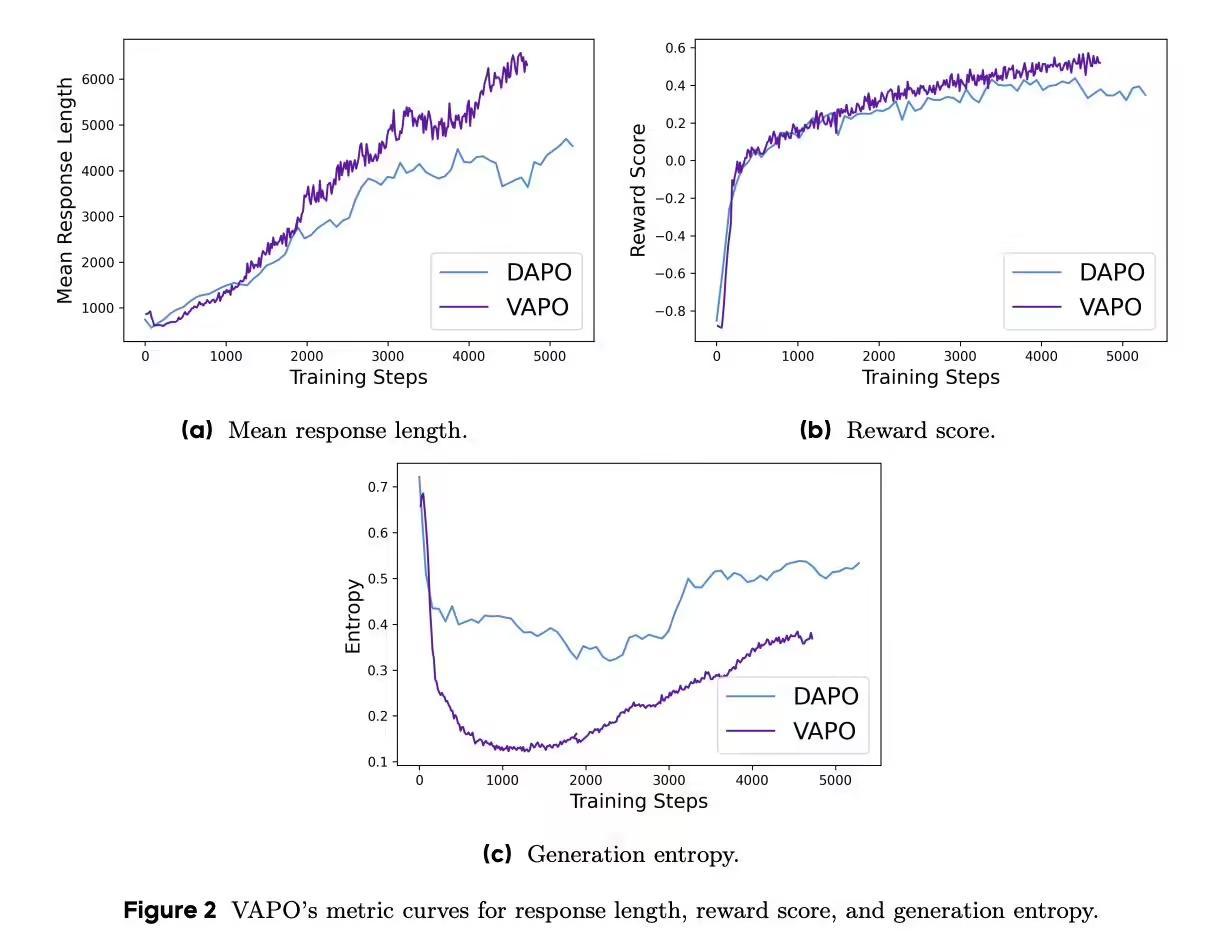

测试表明,VAPO 在长序列任务中表现良好且得分增长较快,这归因于其价值模型所提供的细粒度信号。虽然后期训练熵值降低可能会对探索有所限制,但 VAPO 通过平衡设计保证了稳定性和可重复性。

VAPO 获得成功是因为其进行了综合优化设计。消融研究对七项技术的有效性进行了验证:价值预训练起到了防止崩溃的作用;解耦 GAE 有助于长回答的优化;自适应 GAE 能够平衡短回答和长回答;剪裁策略会鼓励探索;词级损失增加了长回答的权重;正例语言模型损失提升了 6 分;分组采样贡献了 5 分。

这些改进让 VAPO 能够在探索与利用之间找到最为恰当的平衡,它比无价值导向的 GRPO 和 DAPO 方法都要优秀很多。VAPO不但提升了数学推理的能力,还为 LLM 在复杂推理任务中的应用给出了新的方向。