在人工智能领域,各大阵营都在竞相使自己的大语言模型能够在尽可能弱且尽可能便宜的硬件上运行,这一消息来自 IT 之家 5 月 4 日的报道。硬件性能越弱,运行大语言模型所需的功耗就越低。然而,是否想过让一个 AI 模型在 1982 年推出的硬件上运行呢?

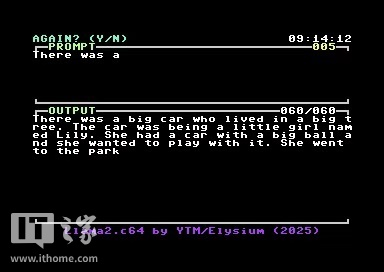

Maciej Witkowiak在其新项目“Llama2.c64”中进行了这样的尝试,据IT之家所知,该项目旨在使一个简单的AI在Commodore 64上运行。

Witkowiak 对该项目的描述如下:

Llama2.c64 由 Maciej“YTM / Elysium”Witkowiak 借助 oscar64 移植到 Commodore 64,它需要 Commodore 64 运行,且该 Commodore 64 至少配备 2MB 扩展内存单元(REU) 。

该项目运行着一个260KB的tinystories模型,此模型把Llama2的功能带到了独特的C64硬件环境里。

要留意,这并非聊天模型。设想给一个三岁的孩子讲述一个故事的开端,他们会凭借自身的词汇量以及能力将故事继续讲下去。

从上图能看到,Llama2.c64生成的故事示例,真的好似一个孩子讲故事时在胡言乱语。不过考虑到AI所依靠的硬件条件那般有限,再加上它在故事里展现出的延续性,对于一台已经43岁的电脑而言,这已是极为令人惊叹的成就了。